外贸网站建设之robots.txt

robots.txt文件是什么

robots协议也叫robots.txt是一种存放于网站根目录下的ASCII编码的文本文件,它告诉robots(通常是搜索引擎)在站点上抓取哪些页面,不要抓取哪些页面。因为一些系统中的URL是大小写敏感的,所以robots.txt的文件名应统一为小写。robots.txt应放置于网站的根目录下。

当一个搜索蜘蛛访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。

robots协议并不是一个规范,而只是约定俗成的,所以并不能保证网站的隐私。Robots协议是国际互联网界通行的道德规范,基于以下原则建立:

(1) 搜索技术应服务于人类,同时尊重信息提供者的意愿,并维护其隐私权;

(2) 网站有义务保护其使用者的个人信息和隐私不被侵犯。

提示:robots.txt文件也称为机器人排除协议,被当作合理的搜索引擎优化黑客。

更多谷歌SEO和搜索引擎优化专业知识,可详询引擎力。

robots.txt文件的基本框架

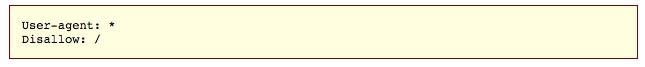

“User-agent”后面的星号表示robots.txt文件适用于访问该站点的所有web机器人。

“Disallow”后面的斜杠告诉机器人不要访问网站上的任何页面。

您可能想知道为什么会有人想阻止web机器人访问他们的站点。毕竟,谷歌SEO的主要目标之一就是让搜索引擎轻松地搜索你的站点,从而提高你的排名。而这就是这个Google SEO技巧的秘密所在。如果搜索引擎抓取你的网站,它会抓取你的每一个页面。如果你有很多页面,搜索引擎机器人会花一段时间来抓取它们,这可能会对你的排名产生负面影响。这是因为Googlebot(谷歌的搜索引擎bot)有一个“爬行预算”。这可以分为两部分:第一个是爬行速度限制,谷歌相关解释:https://webmasters.googleblog.com/2017/01/what-crawl-budget-means-for-googlebot.html;第二部分为抓取需求,基本上,抓取预算是Googlebot可以和想要抓取的url数,你要帮助Googlebot以最好的方式为你的网站花费爬行预算。换句话说,它应该抓取你最有价值的页面。根据谷歌的说法,有一些因素会“消极地影响站点的爬行和索引”。

影响爬行预算的因素

根据我们的分析,拥有许多低附加值的url会对网站的爬行和索引产生负面影响。我们发现,低附加值的url可以分为以下几类,按重要性排序:

(1)分面导航和会话状态

(2)站内重复内容

(3)404错误页面

(4)被黑的页面

(5)无限空间和代理

(6)低质量和垃圾内容

在这样的页面上浪费服务器资源会导致抓取活动从真正有价值的页面中消失,这可能会导致发现站点上好内容的时间延迟。通过正确地使用robots.txt,您可以告诉搜索引擎机器人如何明智地使用它们的爬行预算。这就是robots.txt文件在SEO环境中如此有用的原因。

如何找到robots.txt文件

如果你只是想快速浏览一下robots.txt文件,有一个超级简单的方法来查看它,这种方法适用于任何站点。你所要做的就是在浏览器的搜索栏中输入网站的基本URL(例如,yinqingli.com, googleseo.cn等), 然后在末尾添加/robots.txt。

最基础的robots.txt文件示例:

User-agent: *

Disallow:

Sitemap: www.example.com/sitemap.xml

需要了解robots.txt文件中使用的一些语法,可以参考谷歌的解释:

https://support.google.com/webmasters/answer/6062596?hl=en

如何优化robots.txt文件

robots.txt文件的最佳用途之一是通过告诉搜索引擎不要抓取站点中不向公众显示的部分来最大化搜索引擎的抓取预算。 如何优化robots.txt完全取决于站点上的内容, 使用robots.txt有各种各样的方法。

几种常见的可排除页面类型:

(1)有目的的重复内容。虽然重复的内容是一件坏事,但是在少数情况下它是必要的和可接受的。

例如,如果有一个页面的打印友好版本,那么在技术上就有重复的内容。在本例中,您可以告诉bots不要抓取其中一个版本(通常是对打印机友好的版本)。

(2)谢谢你的页面。感谢页面是营销人员最喜欢的页面之一,因为它意味着一个新的询盘。实际情况中,有些感谢页面 可以通过谷歌访问。这意味着人们可以访问这些页面,而不需要经过咨询过程,通过屏蔽感谢页面,可以确保只有咨询者能够看到。

(3)用户登录注册页面

robots.txt测试工具

Tags:

未注明作者或来源均属原创文章,转载请注明:转自 Google优化-引擎力

本文链接地址: https://www.googleseo.com.cn/waimaowangzhanjianshezhirobottxt.html